En octobre 2024, le Cybathlon a présenté les robots assistants : des bras robotiques attachés à des fauteuils roulants qui permettent aux personnes paralysées de faire les tâches quotidiennes qu’elles ne pouvaient plus accomplir du fait de leur handicap. Ces robots étaient contrôlés soit manuellement, soit par la voix, avec ou sans recours à une intelligence artificielle. Une nouvelle approche pourrait rendre ce contrôle plus naturel, en donnant à l’utilisateur la possibilité de guider son robot uniquement par la pensée. Des chercheurs de l’Université de Californie à San Francisco ont présenté dans le journal Cell, le 6 mars 2025, un implant cérébral qui décode l’intention de l’utilisateur et la transforme en ordres pour le bras robotique. Cette technologie pourrait faciliter l’adoption de ces robots assistants, donnant ainsi davantage d’autonomie aux personnes paralysées.

Une approche difficile à mettre en place

D’autres bras robotiques contrôlés par la pensée avaient déjà été testés par le passé. Mais leur utilisation était ponctuelle et ne durait pas plus que quelques jours, en raison de la difficulté à décoder correctement l’activité cérébrale de façon consistante dans le temps. En effet, des études précédentes ont montré que cette activité peut légèrement bouger d’un jour à l’autre, des micromouvements qui sont pourtant suffisants pour perturber le décodage de l’information.

Une danse entre la pensée de l’utilisateur et l’IA

Pour mieux comprendre ce phénomène de dérive qui bloquait l’utilisation de ces interfaces cerveau-machine sur le long terme, les chercheurs ont analysé sur plusieurs semaines l’activité cérébrale de deux personnes tétraplégiques. L’interface utilisée était posée sur le cortex moteur où, à l’aide de ses 128 électrodes, elle captait l’activité neuronale lorsque l’utilisateur imaginait bouger sa main droite. Puis, une intelligence artificielle décodait cette information et l’utilisait pour guider une main virtuelle, affichée sur l’écran d’un ordinateur.

À chaque fois que la personne imaginait faire le mouvement en question, l’activité cérébrale pouvait changer très légèrement, reflétant probablement la plasticité neuronale du cerveau. Mais le fait de voir à l’écran l’action produite par leur pensée permettait aux participants d’affiner leurs commandes cérébrales, ce qui ensuite aidait l’IA à apprendre à mieux les décoder. “Cet apprentissage combiné entre l’humain et l’IA est la prochaine étape pour ces interfaces cerveau-machine”, s’enthousiasme le neurologue Karunesh Ganguly, auteur de l’étude, dans un communiqué.

L’IA peut s’adapter aux changements de l’activité cérébrale dans le temps

Ces changements de l’activité neuronale lors d’un mouvement étaient plus ou moins marqués d’un jour à l’autre. Le profil de l’activité restait le même, mais il se déplaçait faiblement, comme un bateau qui dérive dans la mer. Cela perturbait le décodage, diminuant la capacité de l’interface à bien interpréter la pensée de l’utilisateur. Les auteurs pensent que cette dérive de l’activité neuronale est particulièrement marquée chez les personnes paralysées, qui ne peuvent pas voir l’action déclenchée par leur pensée et donc ne peuvent pas l’affiner.

Mais l’IA pouvait être entraînée pour appréhender cette dérive en analysant comment l’activité avait bougé durant les jours précédents. Ainsi, le dispositif pouvait s’affiner lui-même, décodant correctement la pensée du participant.

Crédit: UCSF

Un bras robotique peut ainsi être contrôlé correctement sur le long terme

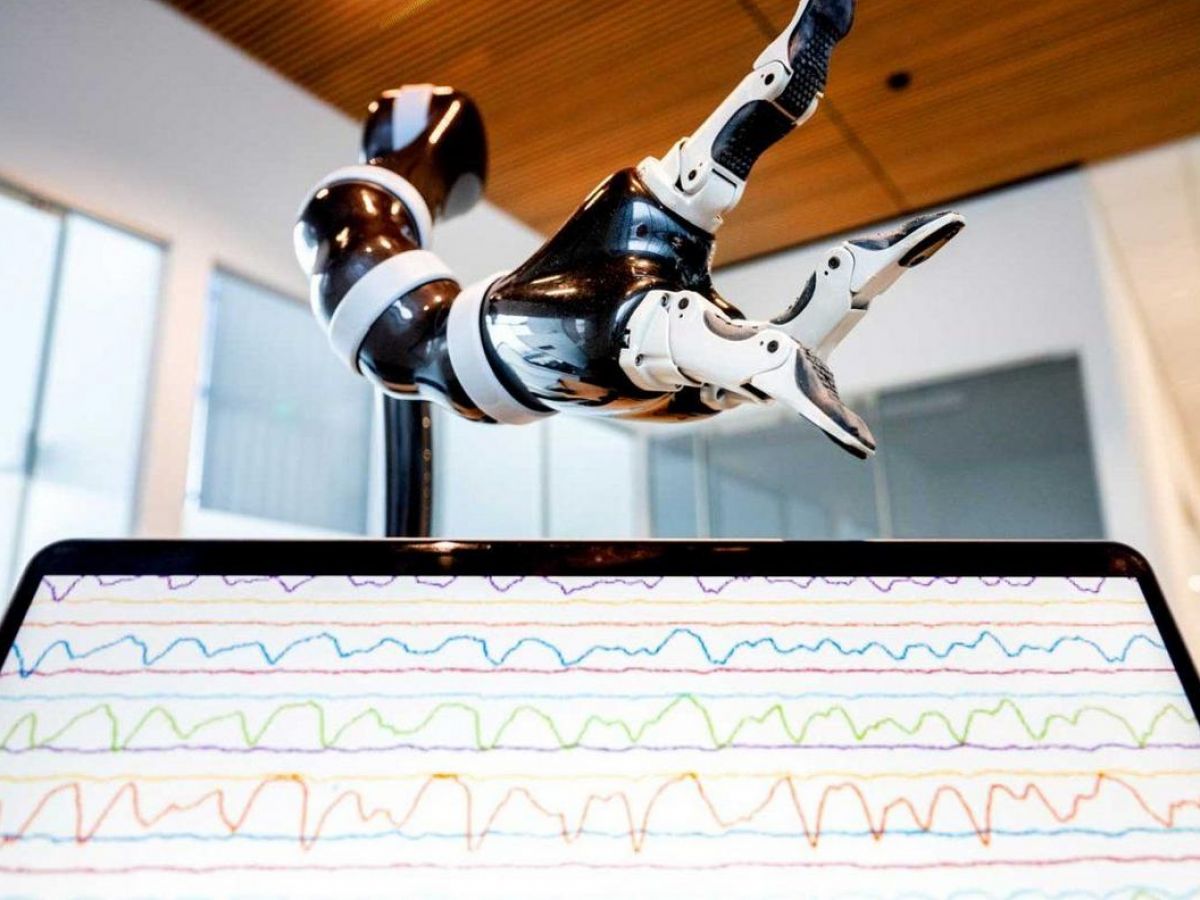

Les auteurs ont ensuite testé l’interface avec un bras robotique, accroché à une table à quelques mètres de l’utilisateur. Celui-ci devait ensuite l’utiliser pour attraper des objets, les manipuler et les déposer à un endroit précis. Les participants ont accompli ces exercices avec un taux de réussite de 90%, mais ils perdaient en efficacité au bout d’un mois. Cependant, une recalibration rapide du modèle d’intelligence artificielle permettait de regagner la précision perdue avec le temps.

Grâce à cette approche, il serait donc possible d’utiliser ces interfaces cerveau-machine pour contrôler ces robots sur le long terme. Les auteurs prévoient que l’ajout de caméras sur le robot (comme en avait le vainqueur du Cybathlon) pourrait encore améliorer les performances de ce dispositif. Car l’IA pourrait appréhender l’environnement du bras et l’objet à saisir, prennant en charge une partie de la réflexion. Notamment pour les tâches répétitives ou celles qui sont plus complexes. Des perspectives encourageantes qui rendraient les robots assistants d’un usage plus facile. Et donc plus utiles.

![김건희·김예성·건진 18일 동시 소환… 귀금속 의혹 집중 조사 [3대 특검]](https://topreadymeals.com/wp-content/uploads/2025/08/5465-eab980eab1b4ed9dacc2b7eab980ec9888ec84b1c2b7eab1b4eca784-18ec9dbc-eb8f99ec8b9c-ec868ced99968a218c725a2c.jpg)